|

2024年7月12日,法国数据守护主管公司法国国家信息自由委员会(CNIL)第1时间发布了关于《欧洲人工智能法》(本文简叫作《人工智能法》)适用的关联问答,促进关联方更加全面理解该法律的适用办法。

1、《人工智能法》的基本状况

1.《人工智能法》有那些规定?

答:《人工智能法》是世界上第1部关于人工智能的综合立法。人工智能系统可能对健康、安全或基本权利形成危害,《人工智能法》旨在为人工智能系统的研发、分发和运用供给一个框架。

四级危害归类

《人工智能法》遵循基于危害的办法,将人工智能系统分为四个级别: 不可接受的危害:《人工智能法》禁止一系列被认为与欧盟价值观和基本权利相悖的有限做法。例如:社会评分系统、利用特定个人或人群脆弱性的系统、运用超越人认识的潜认识系统、在公共空间运用实时远程生物识别系统、针对个人的预测性警务系统、工作场所和教育公司中的心情识别系统。高危害:《人工智能法》针对高危害人工智能系统提出尤其需求,由于它们可能影响个人的安全或其基本权利,因此呢其研发需要遵守更高的需求(合格评定、技术文档、危害管理机制)。这些系统包含(1)列在附件一中,已然受到市场尤其监督的制品,重点触及医疗器械、玩具、车辆等尤其行业中嵌入的人工智能系统。(2)在附件三中列示的八个特定行业的人工智能系统,例如生物识别系统、用于招聘或用于执法目的的系统、关键信息基本设备中的系统、教育和就业中的系统、公共服务资格管理的系统。特定的透明度危害:《人工智能法》对人工智能系统施加了特定的透明度义务,尤其是在存在显著操作危害的状况下。例如,运用聊天设备人或生成内容的系统。例如,包含生成合成音频、图像、视频或文本内容的通用人工智能系统的供给者,应保证人工智能系统的输出以设备可读的格式标示,并可被检测为人工生成或篡改。情绪识别系统或生物特征归类系统的安排者应向接触该系统的自然人通报该系统的运作状况。人工智能系统的安排者在生成或操作形成深度伪造的图像、音频或视频内容时,应披露该内容是人为生成或操作的。低危害:针对所有其他人工智能系统,《人工智能法》无施加特定义务。按照欧盟委员会的说法,日前在欧盟运用或可能在欧盟运用的绝大都数人工智能系统都属于低危害系统。2.通用人工智能模型的关联规定是什么?

《人工智能法》为“通用人工智能模型”专门构建了一个框架,尤其是在生成式人工智能行业。这些模型的定义是它们能够服务于海量任务(例如大型语言模型(LLM,如Mistral AI或OpenAI机构供给的模型),因此呢很难将它们归类到以前的类别中。

针对通用人工智能,《人工智能法》规定了几个层次的义务,从最低限度的透明度和文件办法(第53条)到深入评定和实施其中有些模式可能需要的系统性危害缓解办法,尤其是思虑它们的影响力:重大事故的危害、乱用于发动网络攻击、有害偏见(例如种族或性别)的传播以及对某些人的卑视性影响, 等等(尤其见序言第110段的描述)。

2、谁将监督《人工智能法》在欧盟和法国的应用状况?

《人工智能法》规定了两级治理结构

1.欧盟层面的治理结构是什么样的?

欧盟层面设立了欧洲人工智能委员会(第65条和第66条),旨在保证《人工智能法》的一致适用,该公司汇集了来自每一个成员国的高级别表率,并汇集了欧洲数据守护监督员(亦叫作为EDPS)做为观察员。欧洲人工智能办公室(欧盟委员会新成立的公司)亦参与其中,但无投票权。

另外,《人工智能法》还引入了另一两个公司,旨在为欧盟人工智能委员会的决策供给信息: 咨询论坛(一个多利益攸关方公司,可就欧洲人工智能委员会和欧盟委员会执行任务供给意见);一个由独立专家构成的科学小组(高级科学家将支持欧盟人工智能办公室监管通用人工智能模型的工作,同期亦能够支持各成员国当局的执法活动)。另外,欧洲人工智能办公室负责监督通用人工智能模型,这些通用人工智能模型的研发者组织同期亦供给衍生系统和模型时,这些人工智能系统和模型亦由欧洲人工智能办公室监管。欧洲人工智能办公室和各个成员国市场监督公司分别对高危害通用人工智能系统拥有监管的职能。

2.国家一级的治理结构是什么样的?

《人工智能法》规定,每一个成员国能够指定一个或多个分部承担人工智能系统的安全监督职能。每一个成员国必须在一年内组织形成正确实施《欧洲人工智能法》的治理结构。倘若在同一成员国内指定了几个分部承担管理职能,必须从中选取一个做为国家联络点,以便于与欧盟公司和公众进行联系。

《人工智能法》无规定各成员国人工智能主管分部的性质,但以下状况除外: 欧洲数据守护监督员 (EDPS),被知道指定为欧盟构成公司;数据守护公司,与海量高危害人工智能系统的市场监督功效相关的数据守护公司(第74条);既有行业分部的监管,已然受到特定行业监管(列于附件一)的高危害人工智能系统仍将受到日前既有公司(例如法国国家药物和健康制品安全局(ANSM))的监管。

3、CNIL将怎样思虑人工智能法案?

CNIL 负责保证人工智能系统和模型能够遵守 GDPR,这是一项基于适用于所有 IT 系统的通常原则的法规。因此呢,它亦适用于为人工智能系统处理或由人工智能系统处理的个人数据,包含当它们受《人工智能法》需求的约束时。

在实践中,CNIL计划依靠这些需求来指点和支持利益关联者遵守《人工智能法》,并经过提出适用规则的综合愿景来遵守GDPR。CNIL认为,这项新法规必须准许参与者更好地认识她们在研发或安排人工智能时的义务。

然而,《人工智能法》亦规定了某些被禁止的做法,其中有些已然得到了数据守护公司的准许。例如,CNIL已然能够经过非目的性抓取面部图像(来自互联网或闭路电视录像)来处罚与研发面部识别数据库关联的行径。

如下所述,CNIL仍然完全有能力应用GDPR,例如,适用于重点公司位置于法国的通用AI模型或系统的供给商,尤其是当她们不受《人工智能法》的实质性需求约束时(法国为Mistral AI或LightOn,爱尔兰为ChatGPT/OpenAI或Google/Gemini)。

在过去的一年里,CNIL起步了一项行动计划,以保证创新型人工智能机构应用GDPR,并促进尊重个人数据权利的人工智能。这包含发布和提交操作办法表,阐明怎样将 GDPR 应用于 AI,并提供广泛的意见。CNIL与人工智能行业的机构合作,并支持其中有些机构的创新项目。

4、《人工智能法》何时生效?

《人工智能法》于 2024 年7月12日在官方公报上颁布,将于20天后(即 2024 年 8 月1日)生效。而后,将分周期实施: 2025年2月2日(生效后6个月):禁止人工智能系统带来不可接受的危害。2025年8月2日(生效后12个月):通用 AI 模型的规则应用。指定成员国一级的主管当局。2026年8月2日(生效后24个月):《人工智能法》的所有条款都适用,尤其是附件三中关于高危害人工智能系统的规则的适用(生物识别、关键基本设备、教育、就业、得到基本私营和公共服务、执法、移民和边境管理管理、民主进程和司法行政行业的人工智能系统)。成员国当局安排最少一个人工智能监管沙盒。2027年8月2日(生效后36个月)对附件一所列高危害人工智能系统(玩具、无线电设备、体外诊断医疗器械、民航安全、农用车辆等)适用规则。另外,人工智能法律的实施将高度依赖欧洲层面的“协调标准”,该标准必须准确定义适用于关联人工智能系统的需求。因此呢,欧盟委员会拜托CEN/CENELEC(欧洲官方标准化组织)起草十项标准。自 2024 年1月败兴,CNIL 始终积极参与其研发。

5、GDPR 和《人工智能法》怎样一起适用?

《人工智能法》是不是取代了《通用数据守护条例》的需求?

答:无。

《人工智能法》并不可取代《通用数据守护条例》的需求。这一点非常清楚。相反,它旨在经过规定研发和安排可信人工智能系统所需的要求来弥补它们。

详细而言,GDPR 适用于所有个人数据的处理,即: 在人工智能系统的研发周期:按照《人工智能法》,人工智能系统或模型的供给者一般被视为GDPR规定的掌控者;在人工智能系统的运用(或安排)周期:按照《人工智能法》的规定,处理个人数据的人工智能系统的安排者或用户一般要按照GDPR承担责任。另一方面,《人工智能法》规定了详细需求,这些需求能够大大有助于遵守GDPR的需求。

6、人工智能法/GDPR:我怎样晓得那些法规适用于我?

因为《人工智能法》仅适用于人工智能系统和模型,而《通用数据守护条例》适用于任何个人数据处理,因此呢有四种可能的状况: 仅适用《人工智能法》:针对不需要处理个人数据的高危害人工智能系统的供给者,无论是其研发还是安排,例如:应用于电厂管理的人工智能系统仅 GDPR 适用:用于研发或运用不受《人工智能法案》约束的人工智能系统的个人数据的处理便是这种状况,例如:用于为宣传目的分配利益的人工智能系统,或专门为科学科研目的研发的系统两者都适用:当高危害的人工智能系统需要个人数据进行研发和/或安排时,状况便是如此,例如:用于自动简历排序的人工智能系统或两者都不适用:针对不触及个人数据处理的危害最小的人工智能系统来讲,状况便是如此。示例:用于视频游戏模拟的 AI 系统

7、《人工智能法》对GDPR有何影响?

《人工智能法》和《通用数据守护条例》监管的对象区别,自然亦适用区别的办法。

然而,遵守GDPR有助于遵守《人工智能法》。例如,《人工智能法》(附件V)需求人工智能系统的欧盟符合性声明中知道其符合GDPR的需求。

另外,《人工智能法》还处理了某些GDPR需求与其自己需求之间的有些紧张关系。为此,《人工智能法》在某些知道定义的点上扩展并取代了GDPR的需求: 《人工智能法》取代了某些GDPR规则,即执法公司在公共可拜访空间中运用实时远程生物识别,这在某些状况下非常有可能(第5条);在特殊状况下,《人工智能》准许处理敏锐数据(在 GDPR 第 9 条的含义内),以检测和纠正可能导致损伤的潜在偏见,倘若绝对必要并受到适当的守护办法(第 10 条);它还准许在其创立的人工智能监管沙箱的背景下复用个人数据,尤其是敏锐数据。 这些沙盒旨在促进拥有重大公共利益的系统(例如改善卫生系统)的发展,并由专门公司监督,该公司必须事先咨询国家委员会,并核实是不是符合有些需求(第59条)。8、透明度和文档:怎样将这些 AI 法案需求与 GDPR 的需求联系起来?

《人工智能法》和《通用数据守护条例》有时会从区别的方向处理类似的概念。

例如,透明度原则和文件需求便是这种状况,这显示二者拥有互补性。

透明度办法

GDPR 规定了透明度义务,重点包含通知数据处理方式(为何、由谁处理、怎样处理、多长期等)。这既适用于研发人工智能系统的数据处理,亦适用于个人或由个人运用人工智能系统的数据处理(因此呢会引起个人数据的处理)。

《人工智能法》规定了非常类似的透明度办法,例如用于训练通用人工智能模型的数据(其名单将按照其第53条公开)或旨在与个人互动的系统(第50条)。

文件需求

《人工智能法》还规定,高危害人工智能系统(第11条和第13条)或通用人工智能模型(第53条)的供给者应向其安排者和用户供给技术文件和信息。文件应包含所执行的测试和合格评定程序的仔细信息。

《人工智能法》还需求某些高危害人工智能系统的安排者进行基本权利影响评定,即FRIA(第27条,重点触及公共行径者和受托执行公共服务任务的公司)。

按照 GDPR 进行数据守护影响评定 (DPIA) 的义务完美地弥补了 AI 法案的这些需求。事实上,DPIA将被推定为高危害人工智能系统的供给者和安排者所要开展的必须动作,但最重要的是,DPIA将能够做为满足《人工智能法》(第26条)关于高危害人工智能系统义务履行需求的文件。

《人工智能法》还规定,安排者能够依赖供给者已然执行的DPIA进行基本权利影响评定(第27条)。因为一起目的是能够采取一切必要办法,限制可能受人工智能系统影响的人的健康、安全和基本权利的危害,因此呢这些分析乃至能够以单一文件的形式汇总在一块,以避免过于繁琐的形式主义。

这些只是两项立法之间互补办法的例子,CNIL会继续积极参与欧洲数据保护委员会(EDPB)的工作,科研适用于个人数据守护的规则与日前正在实施的《人工智能法》之间的相互功效。这项工作旨在更清楚地阐明区别法律之间的适用关系,同期加强 CNIL与其欧洲同行之间的统一解释。

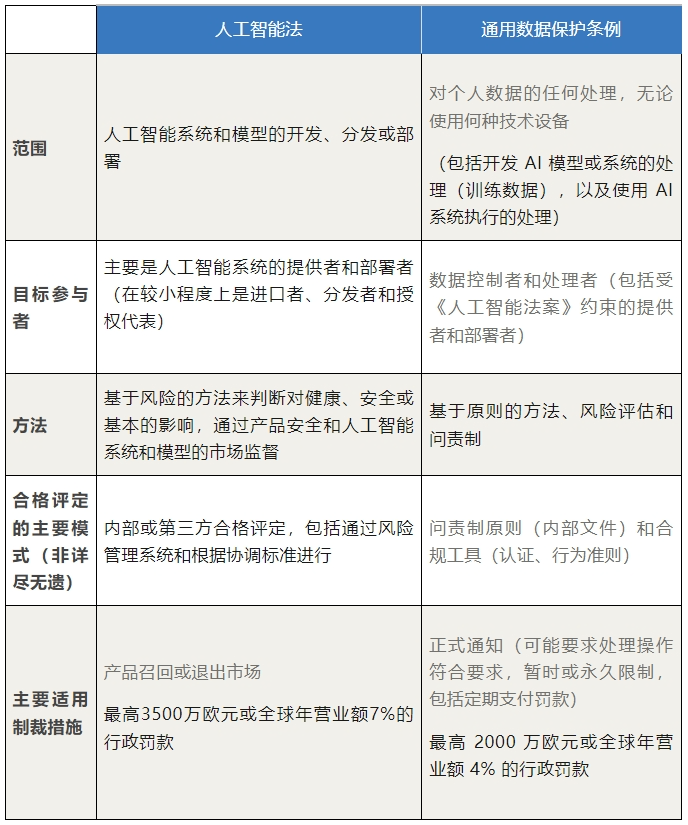

总结:《人工智能法》的需求和《通用数据守护条例》有什么区别?

《人工智能法》和《通用数据守护条例》拥有很强的类似性和互补性,但它们的范围和办法区别。

《人工智能法》和《通用数据守护条例》重点内容对比表

源自:CNIL官网,清华大学智能法治科研院

编辑:lancelot

返回外链论坛: http://www.fok120.com,查看更加多 返回外链论坛: http://www.fok120.com,查看更加多

责任编辑:网友投稿

|