半导体工程师 2024-03-30 08:19 北京

前不久的GTC上,英伟达颁布了一个叫NIM的东西。况且颁布会起码1/4的篇幅都在讲NIM。这东西可能与世界的将来有很大的关系...

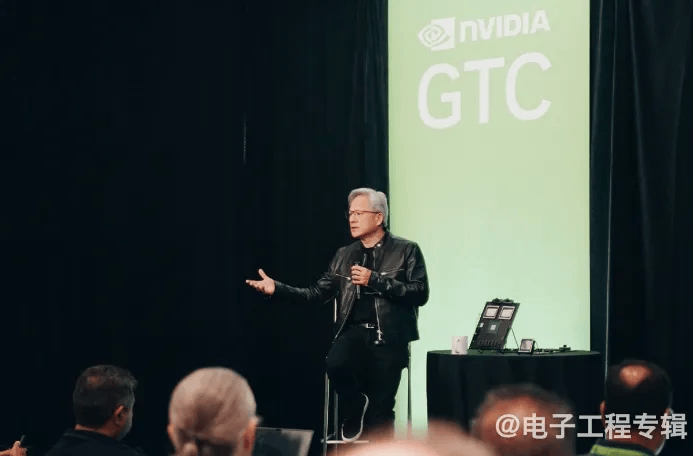

过去1年内,英伟达的市值始终是媒介们关注的焦点:突破万亿、一晚上间又涨了xx、打破记录...前不久的英伟达GTC大会采访时期,黄仁勋谈到:“有人说光是卖芯片,很难卖到2.5万亿市值水平。我没法不赞同这个观点。”“因此英伟达必定不是个芯片机构。”这是他的原话。

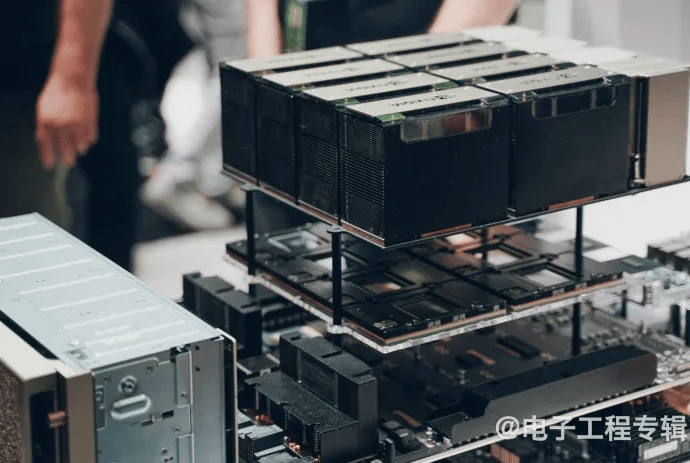

单从英伟达正在出售制品的方向来看,即便是硬件制品,芯片亦的确并非英伟达独一在卖的制品类型,板卡、超级计算机、交换机、机架和计算系统等等都是英伟达在推的制品;况且实际上英伟达的制品亦远不限定在硬件方面,各类加速库、中间件、软件、云服务乃至算得上是英伟达生态的核心构成部分...

咱们总结今年GTC,黄仁勋颁布的几个核心制品包含Blackwell GPU及其系统,面向研发者供给Omniverse Cloud API,人形设备人Project GROOT项目,以及在我们看来这次制品颁布最要紧的NIM(NVIDIA Inference Microservice,英伟达推理微服务)。超过一半都不是硬件——NIM在咱们看来还将是英伟达将来普及、巩固自家AI生态的重要。

这篇文案,咱们借着NIM来谈谈现周期英伟达眼中的生成式AI,及英伟达的生成式AI生意打算怎么做。

将来是“生成”的将来

黄仁勋在分析师问答会上提出了一个特别有趣的想法。他说咱们针对文本、图像、视频、声音等等内容的理解,实现了针对它们的数字化。之因此生成式AI能够与人进行文本和图像的对话沟通,前提在于文本与图像已然被数字化和理解。

“那还有什么是能够实现数字化的?其实咱们还数字化了非常多东西,包含蛋白质、基因、脑波等等——只要咱们理解其结构,或从中抽象出特定的模式,能够理解其内涵,就能做数字化。”黄仁勋说,“那样或许就能够对它们做‘生成’了。这便是生成式AI革命。”换句话说,倘若万物皆可数字化(digitalized),那样万物就可tokenized。

“火速会有个行业是专门生成token的。我晓得这听起来很奇怪。”他用第二次工业革命,即电力革命做类比,“很久之前的工业革命产生了一种新的业务模式,产生的东西亦是看不见的,但咱们后来还必须专门掏钱购买这般的东西,单位是千瓦时,亦便是电力。”和发电同样,“咱们将来会必须生成信息,生成token”,况且是深刻“融入到生活中(for a living)”。

从计算机行业的方向来看,以前咱们的运用习惯始终是对已存在信息的“检索/获取(retrieval)”,一切都是预先做好的(pre-recorded),“写入到了文件里面的”,“可能是图像、视频、声音等等”。“就像我今天早上看的资讯,都是由于人们提前写好的。手机上弹出的宣传亦是。”

“而将来则会是生成的。基于种子信息(seeds information),由上下文做加强”,“最后呈现给你的都是生成的”。“此刻咱们看手机,上面展示的每一个(图像)像素都是一种重新获取(retrieve)行径。但将来,这些像素都会是生成的。”“大部分计算体验都会是生成的”,“与你交互的大部分东西都会是生成的,由于它能够理解你,理解上下文。”

生成的“token能够是化学、医疗、动画、设备人、3D图形”,“倘若咱们能够生成文本的下一个token,那就能生成图像、视频、机械臂的下一个token。”黄仁勋说。其实用更通俗的话来讲,现周期便是基于文生图生成玩滑板的猫,或让设备人倒杯咖啡这类最后实现。只不外此刻共识的实现办法是生成式AI。

没疑要达成黄仁勋眼中的这种将来,英伟达此刻要做的便是连续推广生成式AI,不仅要有Blackwell、GB200-NVL72这类能够算力支撑的硬件,为研发者供给AI研发工具,还必须引导不睬解怎样将AI引入到生产力及公司流程中的个人和公司。这应该是形如NIM这类工具诞生的基本。

让生成式AI设计芯片?

英伟达其实始终很清楚,非常多公司对AI是存在困惑的,尤其是怎么用,能达成何种效果之类的问题;更不消说对模型做优化,将必要的计算栈都搭建起来。因此黄仁勋说“咱们想了个办法”,“一种让你能够接收和操作软件的办法。软件就放在一个数字盒子里。”“这个盒子便是NIM。”

在谈NIM到底是什么的问题之前,先聊一个英伟达自己内部已然在用的东西叫ChipNeMo。简单来讲,这是个懂得芯片设计的LLM大语言模型。跟它聊天,就能得到非常多关联芯片设计的回答。

其实在去年GPT大火以后,相关用生成式AI来设计芯片的讨论就时常冒出来。主打的便是不写一行代码,就靠聊、提需求,让LLM写出代码。不外过去一年咱们问了好些EDA公司,这么做是不是真的靠谱。大部分EDA公司的态度都是,真正走向量产的芯片设计真要这么搞,基本是天方夜谭。

不外起码暗示LLM能够辅助芯片设计。英伟达首席专家Bill Dally在分析师沟通会上说ChipNeMo在内部重点扮演3个角色。其一是让初级水平的芯片设计师,在有问题的时候就直接问ChipNeMo,这般不会浪费哪些高级芯片设计的时间;其次是对bug报告做总结,由于硅工们写的bug报告有时又长又繁杂,况且经常仅有自己能看懂,那样ChipNeMo此时就能够为旁人理解bug报告起到很大的帮忙功效;最后,ChipNeMo的确能生成Verilog,不外通常英伟达不会这么去用...

这个ChipNeMo是怎么做出来的呢?首要以Llama 2 70b为基本模型,放进NIM里面。“倘若你此时问她们,CTL是什么。它给出的回答通常是一种常规知识贮存,不是咱们必须的。”由于此时的模型便是个普通的通用基本模型。英伟达要做的是告诉模型,在英伟达的语境中CTL是什么。之后再问它就能得到正确答案。

当然,要让模型专门适配芯片设计,要做的事情不止这一点。倘若你关注过咱们之前对NVIDIA AI的报告,必定晓得NeMo。准备好关联数据,基于NeMo服务来对基本模型进行fine-tune, guardrail...详细的流程参见下图。

对用户来讲,这其中三个核心构成部分,第1是要有个AI模型,以及能跑AI模型——这是英伟达要先打包给用户的;第二,必须有这般一个工具对模型做“修改”;第三是安排,不管是安排到DGX Cloud云上,还是安排在本地基本设备。完成以后,就能把这东西打包带走了。这便是NIM。

听起来是不是颇有一种公司版Chat with RTX的感觉——Chat with RTX是面向个人用户,能够一键安装,而后加入本地数据,基于你电脑上的个人信息,与AI对话的应用。不外Chat with RTX的外边数据结合,用的是RAG(retrieval augmented generation),前不久咱们还在文案里提过。

况且很巧的是,GTC时期,在一场面向分析师的问答会上,英伟达好几名高层都认为,公司最初还不确定对AI投入多少的时候,都倾向于选取RAG,由于这是公司自己应用生成式AI最简单的方式。乃至有人说到,RAG针对初期的公司AI应用而言是个PoC——概念验证。

“而今年人们会真的起始去打造有价值的AI制品,真正着眼在整体。”这仿佛便是NIM诞生的基本,亦是英伟达推GB200-NVL72这类硬件制品的基本。换句话说,便是在英伟达看来,过了最初期的探索,公司逐步要认真思虑用AI技术了,那便是时候给她们供给基本设备、供给工具了。

有一种定位叫AI Foundry

这儿把NIM再说得知道有些:英伟达给出有些LLM模型,其中有些是英伟达自己做的,有些是开源的,还有有些来自合作伙伴。公司客户能够直接拿来用,况且能够基于自家内部数据,借助英伟达的工具,来fine-tune这些模型,真正让模型为自己所用。形影像ChipNeMo这般的工具。这个服务叫做NIM。

不外倘若要说NIM的确切形成,实质还是比较繁杂的,包含各样预训练模型、及各样跑模型的依赖包,如CUDA, CuDNN, TensorRT-LLM, Triton Inference Server等等……上接AI API。这部分咱就不细说了,有兴趣的去科研下英伟达的博客与文档——不外从这些中间件,其实亦能看出,英伟达要为公司处理模型优化之类的问题,而不单是供给和修改模型(当然重要亦包含要卖跑在下面的硬件,和NVIDIA AI公司处理方法)。

尔后,公司能够创立非常多个NIM,或说非常多个AI聊天设备人。某些工作是必须指派给区别的AI去分别完成的,区别的NIM能够协同工作。关于多个NIM间的协作,黄仁勋做了举例说明,但咱们没能完全理解。不外框架大致便是这个样子了。

针对持有海量数据,但不晓得该怎么用来搞AI的公司而言,NIM理论上会是个不错的工具。由于NIM的价值之一,便是对公司专用的数据做出理解——形成专门的AI数据库,而后进行“re-index”——re-index这个词感觉用在这儿尤其合适。用户就能够和这般的AI对话了——它和ChatGPT有着很大区别。

这儿供给给NIM的公司私有数据能够是多模态的,例如说PDF文档。至于详细是什么样的数据,例如说针对软件团队来讲,能够是一堆平常写的bug报告和总结。那样工程师就能和AI对谈相关机构软件的bug问题,不管是此刻有多少bug,还是处理状况怎么样等等。

黄仁勋在这儿列举了一个多NIM的例子。例如你做为机构软件工程师,和这般一个bug聊天AI对话以后觉得非常受挫,就能够去和另一个专职心理健康的AI继续对话,接受安慰和心理辅导——后者亦能够是基于NIM做出来的…

当然了,他举这个例子应该纯粹是为了谈Hippocratic AI的LLM,协同NVIDIA ACE打造的医疗健康数字人的;不太多NIM协作大概便是这么个意思了。医疗健康亦是英伟达这次谈及的重点,本文就不做展开了。

如此一来,所有的公司都能够做出属于自己的Copilot,属于自己的对话AI——不管这个Copilot是面向公司内部,还是做为服务供给给客户。黄仁勋在主题演讲中宣布了不少NIM关联的首波公司合作,包含SAP, ServiceNow, Dell, Cohesity等。

值得一提的是,做为一种试用手段,英伟达还尤其开放了ai.nvidia.com这么个网址,供给相对直观的NIM试用。

这里时期,黄仁勋反复说到了英伟达做为“AI foundry”的设定,说法上是针对LLM,“并非创造,而是生产(not create it, but manufacture it)”,是为英伟达做为AI foundry的定位。“你去跑这些模型,规模化运行的时候,向咱们支付的其实只是AI操作系统的钱。”黄仁勋说,“操作系统亦便是NVIDIA AI Enterprise”,“非常划算”…就差没讲“buy more, save more”了…

而AI foundry的本意,亦在于让公司客户的AI模型用于生产环境。

GPU回归“生成”的最初使命

最后谈一谈NIM的潜在可能性。咱们针对NIM的第1眼认知是,这是英伟达普及、巩固AI生态的制品。虽然这两年咱们始终在谈AI,但各行各业针对AI,尤其是生成式AI的利用还非常初期。

就如前文谈到的,即便是最前沿的电子科技公司,初期都还在用RAG做AI的PoC。可见AI的发展之路还很长。英伟达一方面要把AI的蛋糕真正做大,另一方面则要尽可能利用现有资源,来连续巩固自己在AI行业的地位——不仅要降低公司用AI的门槛,同期借助与模型合作伙伴的合作,让更加多的AI资源为自己所用。

NIM显然是肩负了这般的职责的。虽然听起来咱们对NIM的定位似乎有些过于高估了。但咱们能够等等看接下来英伟达针对NIM的推广会是怎么样。

回到最初谈世界最后会像需求电力同样,需求“生成token”的疯狂说法——其实黄仁勋的这一说法或许仍然没法被大都数人所接受,尤其从规律上要理解“生成”什么,人们又怎样像消费电力同样消费“生成”内容的问题。这就只能交给时间去评断了。但千行百业都真正起始用AI、生成式AI,这才是世界、个人最后全面步入AI的开端。

有个相关“生成”和英伟达自己的说法特别有趣。“30年后的今天,咱们又回到了最初的那个咱们。”黄仁勋所说的“最初的”英伟达,指的是最初做图形渲染加速的英伟达。由于GPU曾经便是干“生成内容”这个活儿的。“咱们生成为了非常多东西,便是计算机图形。”

“咱们此刻要回到那里了。只不外此刻用来‘生成’的计算机更大了,况且是为每一个人‘生成’。”这还真是相关AI和图形,相当浪漫主义的一种说法。

源自于电子工程专辑,作者黄烨锋

半导体工程师半导体经验分享,半导体成果交流,半导体信息颁布。半导体行业动态,半导体从业者职业规划,芯片工程师成长历程。返回外链论坛:http://www.fok120.com/,查看更加多

责任编辑:网友投稿

|